VERSO IL NUCLEARE PULITO

Scoperta e Sfruttamento

delle Reazioni Nucleari Ultrasoniche

UNA RICERCA TUTTA ITALIANA

--------------

IL GOVERNO SEMBRA PERÒ NON TENERNE CONTO E PREFERISCE

COSTRUIRE LE NUOVE CENTRALI CON TECNOLOGIE VECCHIE

E INQUINANTI ALL'URANIO. INDOVINATE IL PERCHÈ?!

a cura di Claudio Prandini)

I probabili 15 siti individuati dal CNR

per le nuove centrali atomiche

INTRODUZIONE

Le nuove centrali nucleari:

dove, quando e con quale tecnologia

Il ddl Sviluppo licenziato, il 14 maggio 2009, dal Senato pone le basi per il ritorno della produzione di energia nucleare in Italia. Ecco le risposte alle quattro domande più frequenti sul ritorno del nucleare.

Quando arriveranno le nuove centrali?

Obiettivo del Governo è il «riequilibrio» dell'attuale generazione elettrica

italiana, ora sbilanciata sul gas, con il ricorso per il 25% al nucleare mentre

una pari quota dovrebbe essere coperta con le rinnovabili e il restante 50% con

le fonti fossili. Saranno necessarie tra le 10 e le 15 centrali nucleari da

1.300 megawatt ognuna. La tabella di marcia prevede la «prima pietra» di tre o

quattro centrali entro fine legislatura da costruire grazie all'accordo siglato

ad inizio anno tra Enel e Edf.

Quanto costeranno e chi le

finanzierà?

Gli investimenti sono almeno doppi o addirittura tripli rispetto a una centrale

a turbogas di pari potenza, compensati da un costo del combustibile molto più

basso e un costo di generazione elettrica teoricamente competitivo. Anche per

l'Italia si sta consolidando l'ipotesi di un consorzio "alla finlandese", con un

pool di produttori associati a grandi consumatori che si impegnano a ritirare

l'energia con contratti di lungo periodo a prezzo prefissato.

Che tecnologia sarà impiegata?

La tecnologia francese Epr non avrà il monopolio. Un primo lotto di centrali

italo-francesi potrebbe essere affiancato da impianti di tecnologia americana,

canadese o russa. In ogni caso si tratterà di impianti di terza generazione e

non di quarta, ancora allo studio.

Dove verranno costruite?

I siti devono ancora essere definiti. Ma gli esperti ipotizzano l'utilizzo

"preferenziale" dei vecchi siti dove sorgevano le centrali nucleari italiane

chiuse dopo il referendum del 1987. L'area di Montalto di Castro, dove doveva

sorgere una centrale nucleare poi riconvertita a policombustibile, viene tuttora

considerata «ideale».

Nucleare pulito convegno Catania Lions

La via italiana alle reazioni

piezonucleari 2003 - 2004

Prima parte

|

|

|

C.N.R. acronimo di Consiglio Nazionale delle Ricerche |

Gli studi sulle reazioni piezonucleari procedettero in Italia secondo la

tradizione della cultura classica italiana ossia per rigorosamente

deduttiva, al contrario della via anglosassone euristica, od a quella che era

stata la via tedesca empirica.

In più si aggiunse la visione di una concezione rigorosamente geometrica dei

fenomeni naturali, ma questa visione non era deduttiva, come quella di A.

Einstein per esempio, bensì induttiva ossia dettata più dai fenomeni stessi,

piuttosto che imposta alla rappresentazione dei fenomeni naturali.

In parole povere un modo di considerare i fenomeni molto pratico che univa al

rigore della deduzione l’elasticità dell’induzione, tutto questo prima di

passare all’esperimento.

Ossia pensare prima di agire, ma pensare senza troppi pregiudizi o preconcetti,

convinti che, purtroppo, la logica della natura non è logica umana, altrimenti

la scienza sarebbe veramente molto facile, forse troppo.

Gli studi teorici che precedettero gli esperimenti furono lungamente dibattuti da vari studiosi di alcune

università

ed istituzioni scientifiche italiane in particolare le Università di Roma La

Sapienza, Roma Tre, L’Aquila, Perugia, Messina e Torino insieme alla massima

istituzione scientifica d’Italia il Consiglio Nazionale delle Ricerche (CNR) .

Vi furono poi contributi di colleghi di altre istituzioni quali l’Università di

Danzica in Polonia, i laboratori europei di ricerche nucleari (CERN) di Ginevra

in Svizzera, le università del Maryland, di Harvard ed il Politecnico di Boston

(MIT) negli Stati Uniti.

L’idea di partenza era che lo spazio attorno ai nuclei atomici non fosse piatto

come un foglio di carta posato su di un tavolo, ma che fosse possibile per le

forze nucleari deformare lo spazio microscopicamente, almeno entro certi limiti.

Questo spazio deformato microscopicamente avrebbe reso ragione delle reazioni

nucleari indotte o catalizzate

|

|

|

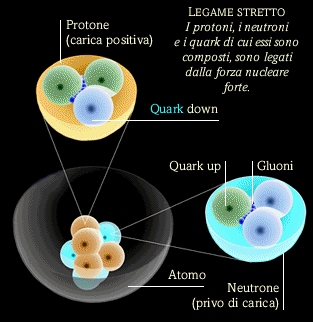

struttura di un atomo |

dalla pressione, ma non solo di quelle note bensì avrebbe aperto la via a nuove possibili reazioni.

Lo

spazio deformato attorno ai nuclei atomici era in analogia a quello che avviene

attorno al sole con la forza di gravità, la quale deforma lo spazio

macroscopicamente costringendo la luce delle stelle a seguire traiettorie curve

e non più rettilinee, proprio come avviene per esempio alle comete.

Ovviamente ci si accorse che questa deformazione microscopica non era facile né

comune, ma si poteva realizzare solo sotto precise condizioni fortemente

vincolate alla energia delle due forze nucleari stesse che sono: la

radioattività, responsabile della instabilità dei nuclei, e la forza nucleare

propriamente detta, responsabile della esistenza stessa dei nuclei.

In particolare venne scoperto che ciascuna delle due forze deformava lo spazio a modo suo, per cui si era obbligati a seguirle separatamente.

Lo

studio si concentrò quindi sulla forza nucleare e nel giro di alcuni anni venne

compreso che la sua deformazione dello spazio era legata ad una soglia di

energia molto precisa ma anche molto alta.

Per cui sarebbe stato necessario concentrare energia in tempi brevi ed in spazi

piccoli per superare tale soglia ed accedere a questo nuovo spazio deformato ove

esplorare quali reazioni e trasformazioni divenissero possibili.

Con un semplice esempio si può vedere cosa significa uno spazio deformato

rispetto allo spazio piatto del foglio di carta sul tavolo a cui siamo abituati.

Prendiamo un foglio di carta bianca, che di solito è rettangolare, tagliamolo

con le forbici seguendo una diagonale del rettangolo ed otteniamo due triangoli

rettangoli.

Poggiamo un triangolo sul tavolo, esso resterà piatto ovviamente, invece l’altro

lo accartocciamo in mano.

A questo punto abbiamo due possibilità teoriche.

|

|

Lasciamo il triangolo accartocciato sul tavolo, e vediamo che è diventato come

una sfera irregolare piena di pieghe interne, oppure lo distendiamo sul tavolo

cercando di farlo tornare piatto con la pressione delle mani ma senza riuscirci

del tutto, infatti il triangolo resterà gualcito e spiegazzato.

In entrambi i casi abbiamo qualche cosa di differente dal triangolo bello piatto

sul tavolo, ora facciamo cadere lentamente delle piccole gocce d’acqua sui

triangoli, o sul triangolo e sulla sfera accartocciata.

Sul triangolo rimasto piatto non ci sono problemi, le gocce bagneranno il

foglio, resteranno sul luogo dove cadono e daranno delle macchie di bagnato

circolari.

Sul triangolo spiegazzato le gocce scivoleranno lungo le pieghe e non resteranno

sul luogo dove cadono, alcune si separeranno sulle creste delle pieghe formando

gocce più piccole, altre si uniranno in fondo alle pieghe formando gocce più

grandi.

Sulla sfera accartocciata la situazione può diventare complicata, alcune gocce

rimbalzano sulle pieghe della sfera e cadono sul tavolo altre scivolano dentro

le pieghe unendosi e separandosi dentro le pieghe stesse all’interno di questa

sfera accartocciata.

Ma se vogliamo sapere cosa fanno le gocce nel triangolo spiegazzato o nella

sfera accartocciata dobbiamo vedere la distanza che percorrono.

Sul triangolo piatto è facile, le gocce sono ferme e la distanza fra di loro può

essere calcolata con il teorema di Pitagora, tanto sono su di un triangolo

rettangolo quindi è ancora più facile, è già predisposto per il calcolo.

Ma proviamo un po’ a fare lo stesso con il triangolo spiegazzato, che cosa

diviene qui il teorema di Pitagora è difficile da dire, ma matematicamente

possibile.

Certo è che nella sfera accartocciata è ancora più difficile, ma ancora

matematicamente possibile.

Se le gocce sono i nuclei delle reazioni nucleari nello spazio deformato,

vediamo così che tutto si riduce al problema matematico di scoprire che cosa

diventa lì il teorema di Pitagora rispetto a quello che conosciamo nello spazio

piatto del triangolo usuale.

L’applicazione di questi criteri geometrici alle forze nucleari portò a capire

che il triangolo spiegazzato corrispondeva allo spazio deformato della

radioattività, mentre la sfera accartocciata corrispondeva proprio alla forza

nucleare che tiene insieme i nuclei stessi.

SECONDA parte

Infatti i nuclei sono composti di neutroni, neutri senza carica elettrica

appunto, e protoni tutti con la stessa carica e quindi che si respingono, per cui senza la forza nucleare i nuclei non

esisterebbero. E’ l’energia di legame della forza nucleare che li tiene uniti ma

non sempre in modo stabile.

carica e quindi che si respingono, per cui senza la forza nucleare i nuclei non

esisterebbero. E’ l’energia di legame della forza nucleare che li tiene uniti ma

non sempre in modo stabile.

Quando l’energia di legame è insufficiente, interviene la radioattività a

governare la instabilità permettendo al nucleo di emettere radiazioni in

successione, trasformandosi progressivamente fino a divenire un nucleo stabile.

Inoltre la somma delle masse dei componenti del nucleo non corrisponde alla

massa del nucleo, c’è il fenomeno del difetto di massa il quale non sempre

corrisponde esattamente alla energia di legame, il che complica la vita a chi

vuole calcolare quanta energia nucleare si può estrarre dai nuclei.

Ma tutto questo và bene sul triangolo piatto, và meno bene su quello

spiegazzato, sulla sfera accartocciata è tutto un’altra cosa.

Quindi bisognava superara questa benedetta soglia per vedere cosa succede nello

spazio deformato della sfera accartocciata.

Divenne subito evidente che un esempio di tale sfera poteva essere il collasso

delle bolle dovuto alla cavitazione, ma ora la visione era più chiara, anche se

più complessa.

Infatti prima gli esperimenti erano stati pensati come se la cavitazione

trasformasse il collasso delle bolle in tante cariche cave nucleari

microscopiche.

Ma non è così, questa è solo una semplice visione superficiale.

|

|

|

(Test di un siluro a cavitazione, la punta (concava) permette la formazione di una bolla d'aria (in velocità) che è in grado di avvolgere tutto il siluro (diminuendo l'attrito). |

Se così fosse stato, bastava accendere il generatore di ultrasuoni e subito si aveva la liberazione dell’energia nucleare, per esempio mediante la produzione di neutroni, invece gli esperimenti statunitensi sia col primo che col secondo modello di macchina avevano in comune una cosa trascurata praticamente da tutti, una sorta di tempo di accumulazione, che nel caso del secondo modello era stato confuso ed oscurato dall’uso degli impulsi di neutroni esterni prima, e dall’uso dell’Uranio poi.

In

realtà la cavitazione è solo un mezzo per concentrare energia sufficiente a

superare la soglia di deformazione dello spazio (per non parlare del tempo)

attorno ai nuclei atomici.

Per concentrare l’energia non è importante quanto grande è la quantità di

energia che si concentra, ma quanto piccolo è il tempo in cui si concentra e

quanto lunga è la durata dell’intervallo di tempo in cui tale concentrazione

viene ripetuta più e più volte.

In pratica serve la velocità con cui si muove l’energia e per quanto tempo si

può mantenere tale velocità.

La velocità dell’energia null’altro è che la potenza (per intendersi il watt o

il suo multiplo il chilowatt).

Poi è fondamentale per quanto lungo tempo si possa applicare questa potenza a

qualche cosa.

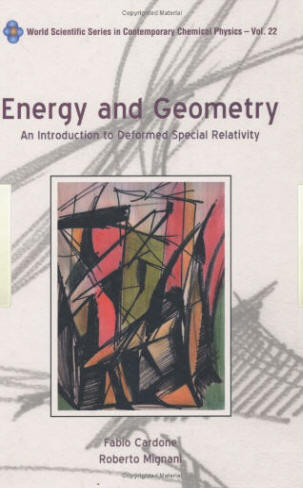

Tutto questo fu riassunto in un volume pubblicato nel 2004 da una delle maggiori

case editrici scientifiche internazionali l’americana World Scientific, che

addirittura, caso eccezionale, ne richiese la pubblicazione di sua iniziativa

senza alcuna richiesta degli autori

(cfr. 10) .

A

questo punto era chiaro dalla teoria cosa era necessario fare, ma restavano due

problemi da risolvere, ovvi però fondamentali : a quale sostanza od elemento

applicare la potenza mediante ultrasuoni e quale fosse la struttura migliore

della macchina ad

ultrasuoni.

ultrasuoni.

Ciascuno di loro era molto complesso ed articolato per cui vanno esaminati in

dettaglio.

Il primo problema era fondamentale poiché la scelta dell’elemento e della sua

forma chimica determinavano la sostanza da usare, la sostanza poi influenzava la

scelta del materiale del contenitore.

L’elemento doveva esser tale da potersi applicare gli ultrasuoni alla massima

potenza tecnicamente realizzabile, per la durata di tempo minore possibile,

prima di superare la soglia di deformazione dello spazio attorno ai nuclei

dell’elemento, il che portava ad innescare le reazioni piezonucleari con la

conseguente liberazione dell’energia nucleare.

TERZA parte

Ma

la teoria aggiunse alcuni dettagli essenziali dei quali tenere conto prima di

passare alla scelta dell’elemento.

Innanzitutto la soglia di deformazione dipendeva da ciascun elemento ed in

particolare dalla energia di legame di ciascun nucleo e se il nucleo dovesse

essere di un elemento radioattivo oppure inerte, leggiero come il Deuterio

oppure pesante come l’Uranio, questo avrebbe determinato la maggiore o minore

durata del tempo di applicazione degli ultrasuoni e quindi influenzava la

necessaria resistenza della macchina.

Poi l’energia nucleare si sarebbe dovuta liberare sotto forma di neutroni in

movimento, la cui emissione però poteva essere discontinua ossia ad impulsi

variabili nel tempo, nella intensità e nella direzione e questo creava problemi

alla loro rilevazione necessaria per stabilire in un secondo tempo l’uso più

conveniente da farne per scopi industriali.

Infine non vi sarebbero dovuti essere raggi gamma poiché la loro energia sarebbe

servita a mantenere la deformazione che permetteva la reazione piezonucleare.

Infatti superata la famigerata soglia i neutroni sarebbero usciti senza essere

accompagnati dai raggi gamma la cui energia sarebbe , per così dire, rimasta

intrappolata nella deformazione, come nelle famose pieghe della sfera

accartocciata. Questo ultimo fatto è comprensibile, poiché, riprendendo sempre

l’esempio del triangolo di carta accartocciato in una sfera, l’energia delle

mani che lo accartocciano deve pur rimanere da qualche parte ed è appunto nelle

pieghe, che danno al triangolo la forma apparente di sfera, il luogo in cui essa

rimane intrappolata.

Passiamo ora al secondo problema fondamentale, la migliore struttura della

macchina ad ultrasuoni.

Scartati il primo ed il secondo modello americani perché manifestamente inadatti

fu necessario considerare le limitazioni imposte dalla tecnologia disponibile

sul mercato.

Infatti la migliore macchina sperimentale, che per giunta era stata realizzata

proprio in Italia all’Università di Perugia, aveva un sistema di raffreddamento

a liquido talmente ingombrante e delicato da usare, da renderla intrasportabile,

inoltre la sua potenza non sembrava essere sufficiente. Ci voleva una macchina

nuova ma che per praticità fosse il risultato della modifica di oggetti

commercialmente disponibili con parti elettriche e meccaniche resistenti e ben

collaudate.

Ma prima di tutto ci voleva un buon progetto concettuale dei suoi costituenti

principali.

Quindi la macchina doveva essere un generatore di tensione elettrica in grado di

produrre in una opportuna colonna di materiali piezoelettrici 20000 oscillazioni

al secondo.

Queste oscillazioni meccaniche dovevano essere trasferite ad un amplificatore di

acciaio che a sua volta le trasferiva ad un sonotrodo tronco-conico anch’esso di

acciaio la cui punta liberava gli ultrasuoni.

Gli ultrasuoni dovevano essere liberati all’interno di una camera di reazione di

forma e dimensioni opportune in modo che la punta occupasse il centro del volume

della camera per rendere massimo l’effetto di concentrazione dell’energia

prodotta con gli ultrasuoni.

Gli ultrasuoni poi dovevano generare la cavitazione nel liquido reattivo

contenuto nella camera in quantità opportuna rispetto al volume utile al netto

del volume occupato dalla punta del sonotrodo.

Il concetto tecnico nuovo era proprio questo: il sonotrodo e la sua punta

dovevano essere separati e distinti dalla camera di reazione contenente il

liquido reattivo, la punta vibrava ma la camera no, doveva rimanere ferma.

Il tutto avveniva a pressione atmosferica ed a temperatura ambiente, anche se

poi durante il tempo di funzionamento vi sarebbe stato un riscaldamento dovuto

alle vibrazioni meccaniche.

Ora rimaneva da scegliere l’elemento da cui tutto poteva dipendere e tale scelta

doveva tenere conto della teoria dello spazio deformato, questo era l’ultimo

passo prima di passare agli esperimenti, ma era il più importante.

Sin dal 1939 era stata stilata e poi sempre più perfezionata la tavola periodica

dei nuclei atomici usando come criterio la massa del nucleo, data dal numero dei

suoi componenti, e l’energia di legame specifica ottenuta dividendo l’energia di

legame del nucleo per il numero dei suoi componenti, questa veniva chiamata

l’energia di legame per componente.

Tavola periodica degli elementi

Tutti i nuclei a

partire dal più piccolo, il Deuterio, fino al più grande, l’Uranio, erano

ordinati secondo il valore crescente di questa energia di legame per componente.

Tra i due estremi vi è il Ferro che si trova circa a metà tra Deuterio ed

Uranio, inoltre il Ferro possiede il valore più alto della energia di legame per

componente tra tutti i nuclei degli elementi ed in più il Ferro è inerte cioè

non è radioattivo.

Per questa sua proprietà di avere l’energia di legame più alta il Ferro è il più

svantaggiato per produrre energia nucleare ed anche il meno incline a farlo.

Scherzando si può dire impropriamente che il suo nucleo è “duro come il ferro” e

quindi sarebbe l’elemento meno adatto da considerare, almeno secondo il normale

buon senso, come avrebbe detto Fermi.

Ma tutto questo in condizioni normali, ossia di spazio piatto. Viceversa nello

spazio deformato delle forze nucleari, il Ferro si trova invece in posizione

avvantaggiata.

Infatti se vi è

una soglia di energia da raggiungere, che è al disopra di tutte le energie di

legame, il nucleo con l’energia più alta è quello più vicino, quello che a

parità di potenza fornita la supera per primo tra gli altri nuclei e, cosa più

importante, nel minor tempo.

Questo è un ragionamento di estrema semplicità ed eleganza che riassume una

serie di ragionamenti e calcoli alquanto complessi, ed è dovuto al fisico

italiano W. Perconti.

A questo punto tutto era pronto, vi era una teoria compiuta e completa che

formulava delle predizioni precise, quali la produzione di neutroni in assenza

di raggi gamma, e permetteva con chiarezza di identificare l’elemento da

sottoporre alla cavitazione mediante ultrasuoni : il Ferro.

Certo è che tutto questo si presentava come un’impresa di un’audacia inaudita.

Ora la scena era

pronta per il dramma dell’esperimento.

Infatti l’esperimento null’altro è che una operazione rivolta alla conoscenza di

una verità ignota, ma è anche un rischio.

Per questo è un dramma, non solo per le idee e per il denaro ma in questo caso

per le persone intese fisicamente.

Poiché nulla nei fatti poteva dire se le reazioni piezonucleari, una volta

scatenate, non divenissero divergenti mettendo a rischio l’incolumità di chi le

aveva scatenate, né tantomeno se fosse possibile controllarle.

Solo i calcoli teorici indicavano che i pericoli potevano essere evitati.

Ma comunque restava un atto di fiduciosa speranza confidare nella esattezza dei

calcoli ed in fondo in chi li aveva eseguiti, che comunque rimase presente in

tutti gli esperimenti a rischiare in prima persona, come un buon soldato e di

soldati infatti ci sarebbe stato bisogno.

APPROFONDIMENTO VIDEO

Reazioni piezonucleari ultrasoniche 1/3

Reazioni piezonucleari ultrasoniche 2/3

Reazioni piezonucleari ultrasoniche 3/3

REAZIONI PIEZONUCLEARI - Aspetti Sanitari

ENERGIA, ALTERNATIVE POSSIBILI